阿里版“马良神笔”来了,轻轻一抹让蒙娜丽莎对你微笑

作者 | 王怡宁

编辑 | 邓咏仪

近半年来,文生视频、图生视频类的工具层出不穷,让人眼花缭乱。但不少实际体验过的用户一定会感受到,脑中的想法转化为语言尚且不易,而人类的语言复杂而精妙,想要再找到准确的提示词,让 AI 正确理解我们的意图,继而转换为图片和视频,实在是太难了。

为了把用户和 AI 都从这种 " 词不达意 " 的困境中解救出来,开发者们做了很多有趣的探索。

比如阿里云科研智算团队近期开源的图生视频模型 Animate Anything,就开发了运动笔刷功能,就像用了 " 马良神笔 " 一般让图片一抹即动。

不仅要动起来,还要准确和真实

一个简单好用的图生视频工具应该长什么样?最近,阿里云科研智算团队给出了他们的答案:高保真 + 高可控性。

Animate Anything 是阿里云科研智算团队从去年 7 月就着手研究的图生视频项目。当时,虽然已经有不少文生图领域的公司如 Midjourney、Stability AI 等走红,但图生视频领域的研究都还非常少,更别说有成熟可用的模型了。

Animate Anything 的开发团队就开始探索通过什么技术让图片动起来既精准、又连贯。

以往 AI 生成视频的一个常见问题是精细度受损——图片在生成视频的过程中,常常容易出现原图被扭曲变形的问题,尤其是在人物面部特征和皮肤纹理这些细节上,导致生成视频很容易就有 " 一眼假 " 人工感,甚至在几秒内就让人 " 改头换面 "。

就像以下这张马斯克的经典图片一样,经过 Gen-2 的 " 巧手 ",简直是本人来了都不敢相认的程度。

图源:X

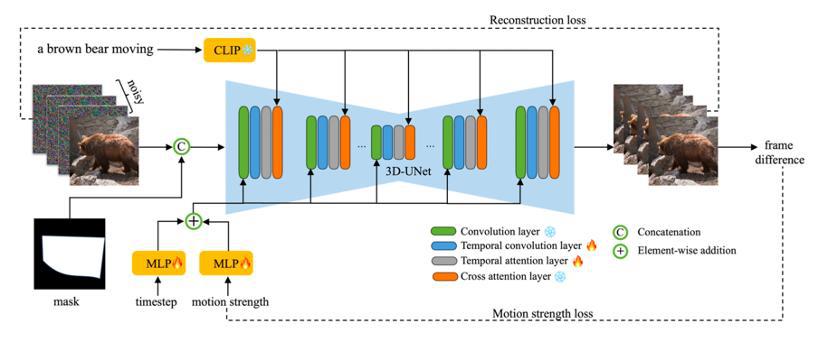

但是,Animate Anything 通过技术手段提高了生成视频对原图像的保真度。团队在阿里 VideoComposer 模型的基础上做了微调,清理过滤了千万量级 HD- VILA-100M 数据集,从中挑选出了 20 万个视频片段。在训练过程中,算法工程师通过保留每一个视频的第一帧,往剩下帧上加入噪声的方法,让网络学习并预测出完整视频。这种方式让图片在 " 动 " 起来的同时,还能对原图的画面保持较高的还原度。

可控性的提高也提升了生成视频的良品率。也就是说,以往用户可能需要生成 10 个视频,才有 1 个符合要求。但现在,用户可以在两三次尝试后就得到一个满意的视频,这有助于用户体验感的提升。

图源:Animate Anything

在图生视频工具的使用中,另一个常常让用户体验大打折扣的点在于,如何让 AI 准确地理解文字提示词。特别是当一张图片所呈现的内容丰富且复杂时,如何能够实现仅仅只让前景或后景的一部分动起来呢?

Animate Anything 提供了一种能够精确控制部分区域动起来的工具 " 运动笔刷 "(motion brush),即使画面繁复如张择端的《清明上河图》,也只要在图上轻轻一抹,就能实现车水马龙的自然流动感。

图源:Animate Anything

据开发团队介绍,这一功能主要是通过在图片上添加「运动图层」(motion mask)来实现的。

简单来说,在训练模型时,算法工程师从真实的视频素材中生成了只有指定区域运动的视频,将这部分区域标记为可动区域图层,再引导网络学习可动区域图层与真实视频之间的运动关系。

最后,当用户输入图片与指定的运动图层以后,网络就可以实现让图片特定区域动起来的效果。

图源:Animate Anything

以上图为例,用户涂抹红色和绿色部分以后,模型结合以往基于在真实视频中添加运动图层的训练,就可以预测行人和游船的动态效果。用户输入图片以后,模型识别到需要动态化的区域,叠加运动图层,就可以让红色区域的行人走动起来,让绿色区域的船穿行水上,实现精准地动态视频生成效果。

除了让图片动起来以外, Animate Anything 团队引入了「运动强度」(motion strength)这一标准,来衡量物体的运动速度,让物体的运动更符合用户的体感。此外,Animate Anything 还提供了更多参数调整的设置,比如可以控制动作的幅度、强度等。

以官方放出的视频为例,运动强度从 4 增强至 20,可以让图中的兔子实现从双耳晃动到全身跳跃的姿态变化。

图源:Animate Anything

图源:Animate Anything

图源:Animate Anything

Animate Anything 开发团队告诉智能涌现,「运动笔刷」和「运动强度」两个功能的引入,颇受合作商的青睐。尤其是对于一些从事传统出版业务的合作伙伴,在数字化过程中,如何解决让以往教科书中的图 " 动起来 " 是关键问题,而运动笔刷和运动强度的控制,为他们提供了一种操作难度更低的选择。

现在,Animate Anything 也已经被集成到了阿里云内部的 " 数字出版 Copilot" 工具中,AI 工具 + 传统编辑器 = 更好用的 Saas 服务,从一线业务出发的导向也让 Animate Anything 早早走通了商业化之路。

构建高质量数据集是技术难点

2023 年是大语言模型的浪潮席卷全球的一年,也是多模态模型不断涌现的一年。

除了 Animate Anything 以外,阿里在去年还发布了多个多模态模型。

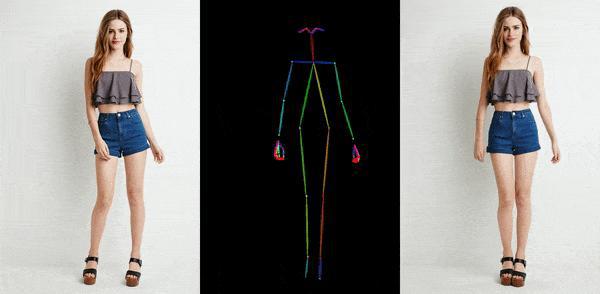

比如,阿里在去年 11 月发布的 Animate Anyone,只需一张人物照片,结合骨骼动画,就能生成人体动画视频。

图源:Animate Anything

目前,基于 Animate Anyone 技术开发的全民舞王已经在通义千问 App 内正式上线。用户只需要上传一张真人或动漫全身照即可生成热舞视频,并且现在支持科目三、秧歌舞、蒙古舞等多种类型。

兵马俑跳 " 科目三 "

不过,这一赛道的竞争也是相当激烈。事实上,就在阿里推出 Animate Anyone 后几天,字节就紧随其后发布了 Magic Animate,还抢先一步实现了开源。

放眼硅谷,竞争同样激烈,Midjourney、Runway 等不断迭代优化,大厂们如 OpenAI 和 Google 也蓄势待发,不断优化着自研模型。

不过,如果说文字领域的 GPT 模型已经迭代到 GPT-4 时代,那么在 AI 生成式视频领域则还处在更早期。不少业内从业者都表示,如今的 AI 生成式视频,技术发展阶段大概在 GPT-2 时代——也就是说,这一领域的 "ChatGPT 时刻 " 还没到来。

从现状看,当前文生 / 图生领域的技术路线尚未收敛,各家厂商都还在技术探索期。Animate Anything 开发团队也表示,图生视频领域还有很多技术难点没有解决。

比如,最大的问题是清晰度受限,以及生成视频时间较短(普遍在 2-3 秒左右)的问题。就算能够拉长视频时长到十来秒,但其中的动作细节、清晰度也无法达到理想水平。

而如果要让视频更长、更清晰,海量高质量的视频训练素材必不可少。所以,如何构建高质量的训练数据集,是未来这一领域的模型构建要解决的关键问题。Animate Anything 开发团队直言:

" 如果构建了高质量的数据集,就已经成功了一半了。"

近期,Stability AI 开源了它们的 AI 视频大模型 Stable Video Diffusion,吸引了更多团队进入 AI 视频生成领域。目前,各家的训练路线还都比较接近,也意味着未来一两年内,这一赛道可能会迎来较为激烈的竞争。

不过,Animate Anything 对后续的产品升级迭代有较为明确的想法,希望增加模型参数和训练视频的规模。此外,团队还计划在目前的基础上进一步加入视频编辑功能,在提升可用性的同时,让这个产品在商业上有更多的想象力。