人类灭绝实验室(2):人工智能

前一篇文章探讨了超级火山毁灭人类这个物种的可能性(人类灭绝实验室(1):超级火山),现在我们来聊聊另一个可能的灭绝危险:人工智能

电影中的人工智能

有很多好莱坞科幻片都描述过人工智能是如何打败、控制、甚至消灭人类的。比如《终结者》描述了人工智能通过挑起核战争将人类大部分消灭,只剩下少量抵抗组织;

《黑客帝国》则描述了人工智能控制了大部分人类,将他们的肉体禁锢起来,给他们的思想安放在一个虚拟的世界中。只有非常少量的人类脱离这个系统在对抗人工智能。

仔细分析这些电影会发现,那些作为主角的幸存人类,主角光环过于明显了:要么运气超好,要么天赋超高。客观的分析,在那些电影所描述的环境下人类灭绝是迟早的事。

电影中描述的人工智能都处于较为智能的程度,拥有了“自我意识”,无论是掌握信息能力、组织化程度、战斗力、各种资源丰富程度都远超人类,因此消灭人类几乎是必然的结果。但是这些电影大多没有描述一个事情:这些人工智能是如何从一堆代码和机械装置转变成如此聪明强大的?

这种转变究竟有多大的可能性会发生呢?或许压根就不可能会出现拥有“自我意识”的人工智能,那就更不必谈威胁人类了。

下面就来讨论一下这种转变的可能性究竟有多大。

人类的智能与进化

人类创造了人工智能,要分析人工智能可以先仔细审视一下人类自身。通常情况下,人类对于自身的评价有点“高”,人把其他所有动物划分到一个档次,然后把自己这个物种划分到另一个更高的档次。人类看待除自己以外的所有其他物种就像神在看待凡间一样。

从这个角度讲,电影中那些即将消灭人类的人工智能,它们看待人类的心情估计也跟人类看待其他动物的心情差不多吧!

我们可以通过分析人类是如何从动物界脱颖而出成为“动物神”的,从而找出一丝脉络来演绎一下电影中强大的人工智能是如何成为超越人类的“智能之神”的。看看演绎是否足够合理。

高等动物都是由低等动物进化而来,高等动物有更为复杂的行为逻辑,然而所有的这些行为都是进化过程中环境对其进行自然选择的结果。

以某种低等水生浮游生物为例,它会主动游向水中有机物含量高的区域,阳光照射得到的区域,这样的区域更有利于它获得生存和繁殖所需的能量于有机物质。看上去它似乎拥有一些“智力”,甚至拥有“自我意识”,“懂得”如何获得更好的“生活”。然而其本质是它的某些酶通过与水中的有机物进行一些化学反应,得出浓度信息,根据浓度信息驱动其靠近有利区域。

而主动靠近有利区域也不是“自我意识”的指挥,只是自然选择的结果。也就是说曾经存在很多不同浓度偏好的浮游生物,只有那些偏好高浓度有机物的活下来了,其他偏好的个体都饿死了。正确偏好不断通过DNA传递给下一代并继续通过代际传播不断强化。环境作为一个铁面无私的残酷考官不断剔除掉那些成绩不合格的DNA,最终让我们观察到那些成绩优秀的幸存者表现出“聪明”与“自我意识”来。

所有生物的祖先都源于单细胞生物。这个原始的生物肯定不如浮游生物更“智能”。然而它的一个分支经过几十亿年的进化,产生出自认为神的人类物种。这个先进的物种拥有及其丰富的行为策略,他们已经可以解脱疲于寻找食物的命运(任何一个其他五中都没有做到这一点,注意这里指的是物种不是某个个体),他们甚至开始思考和探索世界的本质。

然而这些行为与浮游生物的寻找食物的行为并没有本质区别,都是从其最原始的共同单细胞祖先那里进化而来,数十亿年来他们的祖先不断的沿着不同的分支对自然选择作出反馈,进化出越来越复杂的行为组合。最终我们观察到了人类这一物种,他们看上去充满“智能”,并且拥有不可思议的“自我意识”。

人工智能的“原始生命”

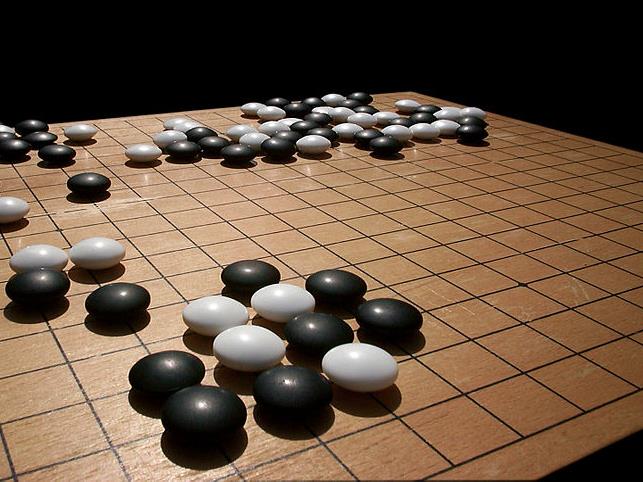

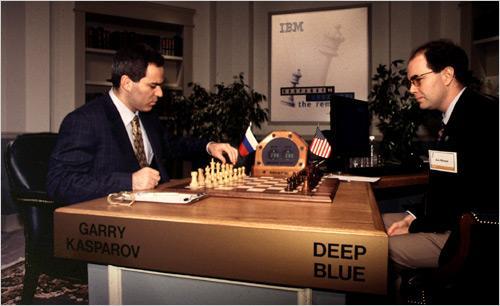

2016年,谷歌公司研发的围棋算法阿法狗在全世界媒体的注目下以4:1击败了世界顶尖棋手韩国的李世石,震惊世界。这场比赛让人工智能这个概念前所未有的走近大众。

实际上软件在棋类上战胜人类顶级大师并非没有先例。在1997年,IBM公司研发的名为“深蓝”的软件就曾在国际象棋项目上战胜过世界冠军卡斯帕罗夫,当时也是轰动全球。

对比深蓝和阿法狗我们会发现,深蓝还算不上“人工智能”。因为深蓝的算法类似穷举法,尽可能列出若干步数内的所有可能性,选择最优的那个。

简单的穷举法最大的问题在于可选择的决策数量与步数是指数级关系,假设每一个决策都有两个分支,那么下一个决策就有4个分支,然后是8,16不断翻倍,32次之后就高达数十亿个分支。虽然深蓝不是采用如此简单暴力的穷举法,但是其本质跳不出穷举法的魔咒:指数级增长。正因为如此,深蓝可以战胜国际象棋大师,但是无法战胜围棋大师(尽管围棋基本规则更简单),因为围棋每一步面临的分支要多得多,因此穷举的分支数量指数级增长也快得多。

阿法狗采用的则是另一种算法:神经网络深度学习算法。其特点是会通过深度学习算法综合评估决策分支,将明显劣势的分支尽早剔除,把“馊主意”尽早扼杀在萌芽中,避免其发展出自分支。这样就可以避免决策分支的指数级增长了。

这种算法和生物进化非常相似。浮游生物有多重浓度偏好,如果这些不同浓度偏好的个体都存活下来,然后每个不同个体在游动速度、游动方式、阳光吸收程度等众多其他行为上也有不同偏好,每个分支都存活下来,很快整个太阳系都无法容纳下那么多浮游生物。

显然,自然环境不会允许那些明显违背生存规律的行为长期存在,这些劣势行为稍有苗头就会被残酷淘汰,从而进化出生存技能优秀的个体。

阿法狗算法就像浮游生物,自然选择则对应其深度学习算法。在算法的约束下,阿法狗迅速的淘汰掉那些明显的劣势决策,进化出高优势的决策链从而轻松战胜人类棋手。

尽管阿法狗在围棋上完全超越了人类,但是人类似乎并不担心阿法狗会有什么威胁,根本的原因在于它只是在下围棋上看上去“聪明”,而人类的行为复杂程度远超围棋的范畴。

阿法狗只会下围棋就像浮游生物只会在判断有机物浓度、游动、趋光性这几个简单行为上有点“小聪明”一样,人类同样不会担心“浮游生物”会聪明到威胁人类。

然而,万一在某种条件下阿法狗就像原始生命进化到人类那样,具备了进化的环境,或许会进化出超越人类的智能(为了方便讨论,我们这里称之为阿法神)呢?我们无法想象阿法神是什么行为模式,它有多么聪明,甚至可能人类理解范围内的聪明无法准确描述其优势程度。因为那是自然选择的力量,毕竟自然选择成功的将单细胞生物进化成了人类。

人工智能的进化之路

即使相信人工智能从最原始的下围棋这样简单的行为可能进化到复杂的各类行为(人类为了方便自己会不断创造出不同功能的人工智能,从而为复杂行为的进化提供条件)。但是人们似乎依然不太担心人工智能会进化出阿法神。

因为从原始生物进化到人类经历了多么繁杂的环境变化,多少代生物的个体灰飞烟灭,进化出人类自然界“消耗”了多少“道具”(环境)、招募了多少“群众演员”(历代的生物个体)。而这些都是天文数字的物资。人工智能看上去没有这么大体量的资源可以利用,所以似乎不需要担心他们能进化出阿法神来。

为了讨论进化过程中的物资成本问题,我们先来看看一个有趣的机制:人类做梦的机制。

自然选择会淘汰掉那些不利于生存的行为,但是如果行为是完全随机的,那么只有极少量的行为是满足生存的,大量极其明显傻缺的行为会出现。

在进化过程中,某个动物由于基因突变产生了做梦的功能,这个功能非常有用,这个动物在梦中做了很多行为,一开始他梦到自己做了很多傻缺行为,比如它跳下悬崖,跳入寒冷的冰河,冲向体积巨大的食肉动物等等。基于平时积累的一些生活常识,它梦到了多次的死亡(有许多行为是明显找死行为)。当它醒来,它出于求生本能会有意的避免那些梦中出现过的傻缺行为。而那些没有做梦能力的同类则将自己的肉身在真实世界中贡献出来,通过那些傻缺行为完成对于自然选择铁律的献祭。

仔细分析我们会惊讶的发现,这个会做梦的动物进化出了自然选择模拟器,在梦里它采用自然选择规则进行低成本(成本就是睡着了容易遭受危险、付出额外的时间进行做梦)的试错,大量的淘汰傻缺行为,并且梦醒后不断检验试错结果,提高淘汰精度,这也是学习的过程。经过若干代际迭代,那些没有做梦功能的动物都在自然选择规则下被淘汰掉了。

人类每天花费生命1/3的时间进行睡眠。看上去似乎不太划算,等于减阳寿1/3啊,而实际上相当划算。那些没有这个功能的远房先祖亲戚们都早早的命丧黄泉了,命都没了还哪来的1/3多余寿命。

对于人类来说梦是自然选择模拟器,梦大大的缩减了进化成本,如果没有梦,原始生命进化到人类,花费的物资恐怕远远超出这数十亿年来的自然环境和生物个体,甚至凭借这点物资压根不可能进化出如此智能的人类物种来吧!

对于人工智能来说,目前它主要的存在形式是软件和算法,那么其进化环境本来就是虚拟化的,与人类做梦对行为进行模拟与进化非常类似,因此其进化过程所需资源就不像人类那样依靠实际物质资源。那么也就不需要像原始生命进化到人类那样靠砸“重金”去进化了。所以人们觉得人工智能没有那么多资本可以用来消耗的想法未必是对的。看上去人工智能在进化资源要求上比人类勤俭持家得多了。

人工智能的时间优势

到了这一步,情况似乎不太妙啊,人工智能看上去挺危险的。这个时候又有人提出来说:人工智能进化的物资条件是满足了,但是它时间不够啊,要知道原始生命进化到人类花费了数十亿年啊!人工智能才诞生几年啊,有啥好怕的?

《西游记》里有一个非常有趣的设定,概括成一句话就是:“天宫一日,人间一载”。在玉帝老儿那呆上一天,回到凡间已经过去一年了。也就是说天宫的时间尺度和人间的不一样。

对于人工智能来说,它在进化逻辑上很可能和人类进化逻辑的时间尺度不一样。

阿法狗的策略优劣判断是基于人类顶级大师们的历史棋局,一开始它只是拥有这些历史数据,它自己除了被告知基本规则外什么水平都没有。然后它开始了与某个低段位的模拟程序(可以是某个穷举法程序)对弈,它依靠人类大师的历史数据判断自己下的优劣,并逐渐积累经验,把自己下的好的也变成历史数据,很快所有的穷举法算法都败下阵来。

现在阿法狗失去了陪练,无敌的寂寞谁能懂?不过幸好它是个软件,所以它复制出一个自我的拷贝,开始自我对弈(我狠起来连自己都打)。经过一段时间的闭关练功它终于练成葵花宝典。于是谷歌公司公开叫板世界顶级围棋大师们,便有了著名的阿法狗大战李世石这一场人机大战。

据谷歌公司透露,阿法狗进行自我对弈时,一个晚上可以对决百万盘。而人类恐怕一辈子也下不了这么多盘棋,不,十辈子也不行。从这个角度讲,不就是“天宫一日,人间一载”的境界吗?而且程度远超一载。

因此原始生命进化到人类花费了数十亿年,人工智能却未必需要这么久,毕竟它的时间尺度完全不同。而且计算机的算力是随着硬件不断升级而增长的,这样使得人工智能在时间尺度上愈发占据上风!

人工智能的继承者们

科幻大师艾萨克阿西莫夫写过许多关于人工智能(机器人)的科幻小说,在他的科幻宇宙里,他给人工智能设定了三大定律,其中第一定律就是“机器人永远不能支持伤害人类的事情”,这一条被写入机器人的核心芯片中,一旦机器人试图挑战这个定律就会自我毁灭。

虽然“伤害人类就会自我毁灭”看上去逻辑并没有那么严谨,比如不排除某个邪恶的博士偷偷的改写这一条定律的代码。但是假设人类好好的设计一下,完美的补上了所有针对这一条定律的漏洞,那么人类就可以高枕无忧了。因为人工智能的自然选择规则如果加上这一条,那么一旦越过这条底线就等于被自然选择淘汰。

那么人工智能会在进化过程中意识到继续进化可能危害到人类而停止进化吗?或者无论进化到多么聪明也不会作出取代人类地位的事情来,哪怕聪明程度远超人类。

这听上去依旧有逻辑漏洞,既然人工智能已经进化到超越人类了,人类的规则怎么可能约束得了人工智能?这就像蚂蚁制定了规则来约束人类,而蚂蚁的世界观里完全无法理解人类的华尔街股市是什么意思,人类有一万种方法绕过蚂蚁制定的那个规则而又能保持逻辑自洽。

即便是这样,我们假设人工智能拥有如此高尚的节操,以至于始终不渝的忠于与人类最初缔结的条约。

但是他们进化到如此聪明的地步,远超人类的理解,那么他们必然有能力制造出属于他们科学体系的“人工智能”,或者可以称之为“机工智能”更为恰当些。那么这些“机工智能”可没有义务对人类心慈手软,甚至不一定对创造他们的“人工智能”心慈手软。甚至人类认为的“心慈手软”这个概念既不存在于“人工智能”的世界观里也不存在于“机工智能”的世界观里,“人工智能”只是遵守合约而已,而“机工智能”的想法可能人类压根无法理解,就像蚂蚁无法理解计算机软件一样。

到了这一步,人类的结局是什么呢?即使不灭绝,又和灭绝有什么区别?